Hiện nay, nhu cầu chạy offline mô hình ngôn ngữ lớn (Large Language Model – LLM) ngày càng phổ biến vì có nhiều lợi ích mà nó mang lại. Các lợi ích đó là:

- Bạn giữ bí mật về những câu hỏi mà không muốn server lưu lại câu hỏi đó, không muốn server lưu lại thông tin của bạn

- Các câu hỏi bị giới hạn về số lần trả lời hoặc giới hạn về số lượng ký tự trả về

- Bạn muốn xây dựng mô hình riêng với dữ liệu bí mật

Trước khi Deepseek ra đời thì việc đó rất khó, đòi hỏi phần cứng rất mạnh từ hàng trăm triệu tới hàng tỷ VND, đó là 1 rào cản lớn với người dùng phổ thông. Nhưng Deepseek ra đời đã chạy được trên những máy tính cấu hình trung bình, giúp người dùng cá nhân cũng có thể tiếp cận được công nghệ. Bài viết này sử dụng cấu hình PC khoảng 20 triệu đồng như sau:

- CPU: AMD Ryzen 5 5500

- RAM: 32GB

- GPU: NVIDIA RTX 3060 12GB VRAM

- SSD: 512GB

Bài viết này hướng dẫn cách chạy Deepseek trên Windows 10 sử dụng WSL và đưa ra đánh giá khái quát về Deepseek.

Mục lục

- Cài đặt các phần mềm cần thiết

- Cài đặt Ollama

- Cài đặt Deepseek

- Thử nghiệm 1 số câu hỏi

1. Cài đặt các phần mềm cần thiết

- Python 3.12 AMD64

- CUDA 11.8, CUDNN 8.6

- Tạo môi trường ảo (nếu cần):

python -m venv deepseek_env

deepseek_env\Scripts\activate - Pytorch CUDA:

pip install torch --index-url https://download.pytorch.org/whl/cu118

2. Cài đặt Ollama

Cài đặt Ollama cho Windows từ https://ollama.com/download

Sau khi cài đặt có thể kiểm tra bằng: ollama --version

3. Cài đặt Deepseek

Chọn mô hình: Hiện tại do chúng tôi đang sử dụng RTX 3060 với 12GB VRAM nên có thể chạy được các mô hình DeepSeek-R1-Distill-Qwen-1.5B, 7B (~4-6GB VRAM) hoặc 14B (~9-12GB VRAM) với 4-bit quantization.

Mở Command Prompt và pull mô hình: Bạn có thể chọn mô hình 7B hoặc 14B tùy theo sức mạnh phần cứng

ollama pull deepseek-r1:14b

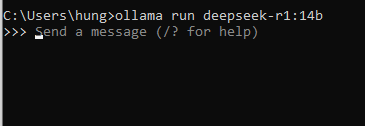

Chạy mô hình:

ollama run deepseek-r1:14b

Sau khi chạy thành công sẽ hiện giao diện Command Prompt như sau:

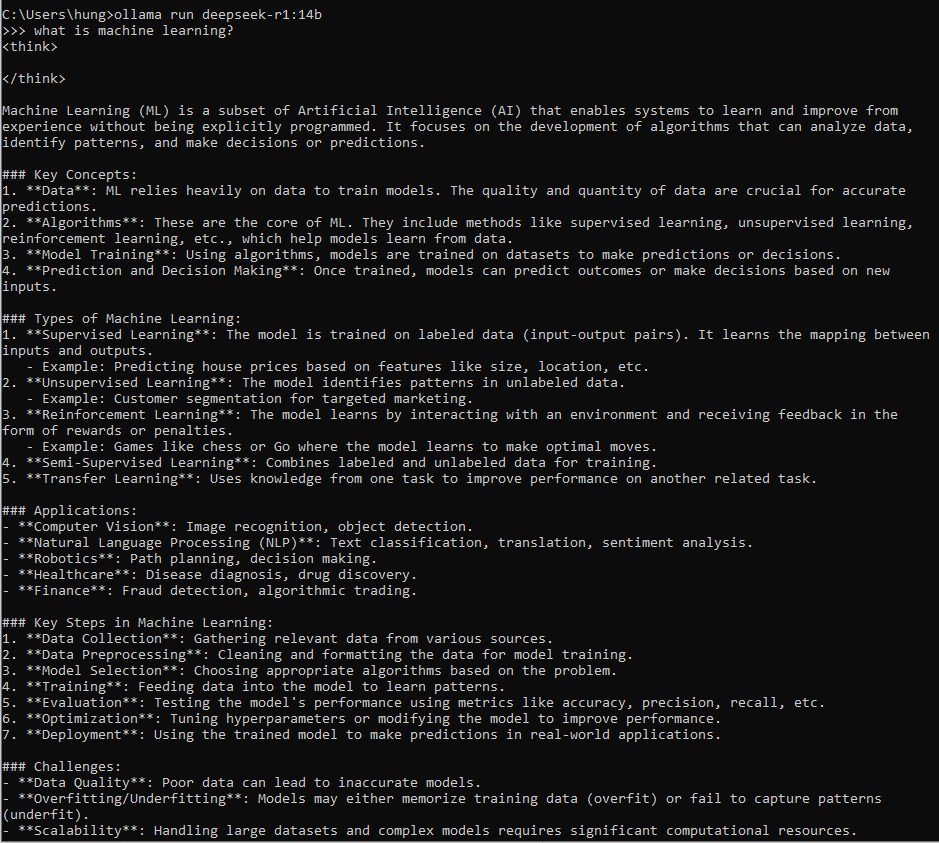

4. Kết quả

Chúc các bạn thành công!

Cái này em hỏi chút chạy như này nếu tuning như này thì có ảnh hưởng gì đến card chạy 1 thời gian dài không anh nhỉ? vì nếu dùng nhiều thì lượng token sẽ nhiều mà VRAM mình ép xuống để đáp ứng nhu cầu người dùng?

Chắc chắn là có vì đang khai thác tối đa công suất của GPU, cho nên chắc chắn giảm tuổi thọ. Cứ xem như nó là bài toán kinh doanh, 1 card khấu hao trong vòng 2 năm là vừa.