TTCT – Vì sao dữ liệu lớn (big data) bỗng trở thành một câu chuyện thời thượng? Và vì sao nay lại có những lời phản bác dữ liệu lớn theo kiểu quay ngoắt 180 độ? Cái quan trọng hơn dữ liệu là gì?

Minh họa: M.N.

Thành phố Boston một hôm bỗng nảy ra một ý tưởng xuất sắc: viết một phần mềm cho điện thoại di động thông minh, kêu gọi người dân cài đặt, bất kỳ khi nào họ lái xe qua ổ gà, ổ voi, máy sẽ ghi nhận cú nhún đột ngột. Hằng ngày, hàng chục ngàn dòng dữ liệu như thế chảy về một trung tâm xử lý sẽ giúp Boston biết ngay đường phố nào đang hư hỏng, mức độ nặng hay nhẹ để cho người đi sửa chữa ngay.

Đó là một ví dụ trong đời thường về dữ liệu lớn và những gì nó có thể làm được. Thử tưởng tượng trước đây làm sao có cách nào có được thông tin đầy đủ về tình trạng sức khỏe đường sá một thành phố lớn theo thời gian thật như thế.

Dữ liệu lớn ở khắp nơi

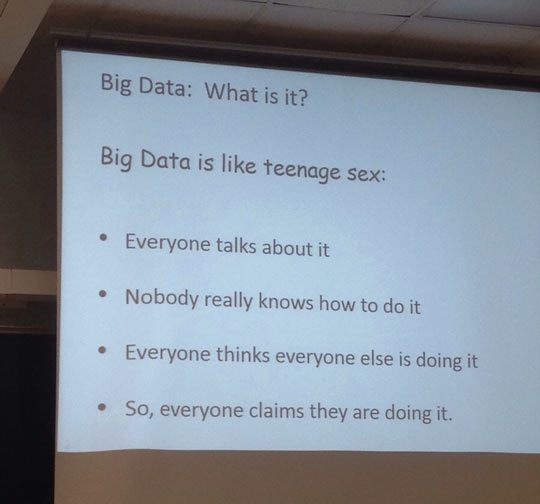

Chỉ trong mấy năm gần đây, dữ liệu lớn, hay nói đúng ra là cách khai thác các luồng dữ liệu khổng lồ để tìm ra những xu hướng, những bức tranh tổng thể, những lớp thông tin nằm bên dưới… đã trở thành một lĩnh vực phát triển nhanh chóng đến mức kỳ diệu.

Hăm hở nhất là doanh nghiệp: họ cứ tưởng giờ đây họ đã hiểu khách hàng tận chân tơ kẽ tóc, dùng dữ liệu mà các gã khổng lồ như Google thu lượm hằng ngày hằng giờ, doanh nghiệp có thể nhắm trúng đích người đang cần sản phẩm hay dịch vụ của mình.

Thực tế đã có những câu chuyện nghe như khoa học viễn tưởng: bạn viết email hỏi người bạn tại Đà Nẵng khách sạn nào là tốt nhất để ở mấy ngày cuối tuần, chưa thấy ai trả lời thì Google cho hiện lên thông tin về đúng loại khách sạn bạn tìm. Từ kho dữ liệu lớn công cộng, một tờ báo biết ngay độc giả tuổi teen của họ đang tìm kiếm những từ khóa gì và tổ chức bài vở đúng y sở thích của những độc giả tiềm năng này.

Có một câu chuyện minh họa cho dữ liệu lớn, không biết là chuyện thiệt hay bịa. Dân tình đồn đoán chuỗi siêu thị Target là nơi sử dụng dữ liệu lớn thành công hơn cả. Một hôm một người đàn ông giận dữ xông vào văn phòng Target ở Minneapolis, la mắng ban giám đốc vì sao cho người gửi tài liệu giới thiệu quần áo trẻ em và tã lót cho con gái ông trong khi cô này đang còn tuổi đi học.

Giám đốc hết lời phân bua và xin lỗi vì có lẽ máy tính nhầm lẫn gì chăng. Bất ngờ thay, một tuần sau ông bố mới thật sự biết cô con gái tuổi teen của ông vừa mới mang bầu. Target biết trước ông bố do phân tích đúng mọi dữ liệu thu thập được từ thói quen mua sắm của cô này.

Sự đời hóa ra không đơn giản

Mọi việc đang diễn tiến tốt đẹp cho ngành khai thác dữ liệu lớn như thế bỗng trong tháng gần đây, hàng loạt tờ báo lớn trên thế giới cùng nhau lên tiếng phê phán việc quá coi trọng dữ liệu lớn.

Tờ New York Times liệt kê tám, chín điều “băn khoăn” về dữ liệu lớn. Ví dụ mối tương quan giữa các dữ liệu có thật tương quan không (từ năm 2006-2011, tỉ lệ sát nhân và tỉ lệ sử dụng Internet Explorer có mối tương quan rất rõ: cả hai đều giảm mạnh; hay từ năm 1998-2007 số lượng ca bệnh tự kỷ được phát hiện tăng nhanh y như mức tăng doanh số hàng thực phẩm hữu cơ. Nhưng có ai dám kết luận mối quan hệ nhân quả nào ở đây chăng!).

Hay con người rất dễ đánh lừa các phần mềm dựa vào dữ liệu lớn. Các chương trình thử nghiệm chấm điểm bài luận sinh viên thường dựa vào các yếu tố như độ dài của câu, sự xuất hiện các từ khó, từ thể hiện độ chín của tư duy… Thế là sinh viên cứ cố tình viết câu cho dài, cứ lâu lâu lại thả vào bài một hai từ “đao to búa lớn” dù chúng không ăn nhập gì đến nội dung. Kết quả bài theo đúng môtip như thế đều được điểm cao.

Điều quan trọng nhất trong các vấn đề mà tờ báo này nêu ra có lẽ là chuyện dữ liệu lớn được thu thập theo một cách, vì một mục đích nào đó nay được đem ra phân tích theo cách khác, vì mục đích khác. Đương nhiên kết quả sẽ bị méo mó, không còn đáng tin cậy. Kho dữ liệu lớn hiện có đến từ nhiều nguồn, nhiều phương pháp thu thập, liệu ai dám đoan chắc chúng được khai thác đúng cách?

Tờ Financial Times viết mạnh hơn, đặt vấn đề ngay trên tựa “Dữ liệu lớn: có phải chúng ta đang phạm sai lầm lớn?”. Tờ này kể lại câu chuyện xảy ra từ năm 1936 khi Alfred Landon ra tranh cử chức tổng thống Mỹ với Franklin Roosevelt.

Tờ Literary Digest làm một cuộc thí nghiệm táo bạo, tiên đoán kết quả cuộc tranh cử bằng cách thăm dò đến 10 triệu người, tức một phần tư số cử tri lúc đó. Sau khi tổng kết 2,4 triệu phiếu thăm dò gửi trả về tòa soạn, một tỉ lệ hồi âm rất lớn, tờ này bèn mạnh dạn kết luận: Landon sẽ thắng với tỉ lệ 55% so với 41%.

Kết quả thật hoàn toàn ngược lại: Roosevelt thắng áp đảo (61% so với 37%). Đau cho Literary Digest là một cuộc thăm dò quy mô nhỏ hơn nhiều của một nhà tiên phong trong lĩnh vực thăm dò là George Gallup (chỉ phỏng vấn 3.000 người) đã có kết quả gần sát với thực tế. Gallup hiểu một điều mà tờ Literary Digest không chịu hiểu: khi nói đến dữ liệu, lớn hay nhỏ không thành vấn đề.

Để từ đó tờ Financial Times cảnh báo về lỗi khi lấy mẫu và thiên kiến khi lấy mẫu có thể làm cho dữ liệu lớn trở thành vô giá trị. Ví dụ tờ Literary Digest lấy danh sách người để gửi câu hỏi từ danh sách đăng ký xe ôtô – một mẫu không mang tính đại diện cho cử tri vì toàn là người giàu có.

Ngày nay người ta hoàn toàn có thể quét hết nội dung trên Twitter của một ngày nào đó rồi dựa vào để phân tích tâm trạng của xã hội vào thời điểm đó, được chăng? Hoàn toàn không vì người dùng Twitter ở Mỹ là giới trẻ, sống ở thành thị hay vùng ngoại ô chứ không phải là toàn bộ dân số Mỹ.

Trở lại với ví dụ về ứng dụng tự động phát hiện ổ gà của thành phố Boston, thực tế đây chỉ là bản đồ tình trạng đường sá của những khu nhà giàu, khu giới trẻ hay lui tới bởi sở hữu điện thoại di động là giới đó chứ không phải toàn bộ thành phố, không phải là các khu nghèo, ổ gà nhiều hơn, cần sửa đường nhiều hơn.

Dữ liệu lớn, dù là cơ sở để doanh nghiệp, tổ chức tiên đoán được tâm lý, thói quen người tiêu dùng, cũng không nên và không thể trở thành yếu tố xác định dòng chảy cuộc sống. Báo mà cứ chạy theo dữ liệu lớn về sở thích đọc tin giật gân của đại đa số thanh niên ngày nay thì không lẽ cứ chiều theo để đăng toàn tin giật gân, bỏ qua loại tin nghiêm túc?

Doanh nghiệp đo lường xu hướng thời trang năm nay xong, không lẽ chỉ sản xuất độc nhất một loại áo bán chạy để tất cả xã hội thành nơi mặc đồng phục? Cái bất ngờ, cái dị biệt luôn là gia vị của cuộc sống – dữ liệu lớn hay không có dữ liệu lớn – không có những ngoại lệ này, cuộc sống sẽ thiếu màu sắc biết bao.

Từ chuyện cảm cúm mà ra

Câu chuyện dữ liệu lớn bùng phát một phần do sự ồn ào Google tạo ra cách đây năm năm. Lúc đó một nhóm nghiên cứu của Google xuất bản một bài trên tạp chí Nature, cho biết họ có thể theo dõi sự bùng phát của dịch cúm ở khắp nước Mỹ một cách chính xác và nhanh hơn Trung tâm Phòng chống dịch bệnh. Đó là nhờ theo dõi và phân tích xu hướng tìm kiếm từ khóa “bệnh cúm” cũng như những từ miêu tả triệu chứng của bệnh này.

Từ đó dữ liệu lớn kiểu “xu hướng bệnh cúm Google” này đã trở thành đề tài thời thượng.

Năm ngoái tờ Nature lại đăng bài nhưng lần này là tin xấu cho Google. Sau khi cung cấp thông tin chính xác về sự bùng phát dịch cúm ở các địa phương trong mấy mùa cúm liên tiếp, nay dữ liệu của Google cung cấp không còn chính xác nữa. Có lúc dữ liệu của Google cảnh báo cúm sắp bùng lên khu vực này hay khu vực khác, nhưng thực tế sau đó không có gì xảy ra cả.

Lý do có thể vì Google đi tìm mối liên hệ nhưng không chú ý đến nhân quả. Ví dụ cuối năm 2012 thế giới đang lo sợ vì dịch cúm, đương nhiên ai cũng đi tìm thông tin chứ đâu phải vì họ có triệu chứng bị bệnh. Hay có thể do Google thay đổi thuật toán tìm kiếm nên kết quả không còn chính xác như xưa. Nhưng câu chuyện cảm cúm của Google đã phản ánh rõ sự thăng trầm của dữ liệu lớn trong mấy năm qua.